Una de las principales defensas que utilizan quienes se destacan en la generación de arte con IA es que, aunque los modelos se entrenan con imágenes existentes, todo lo que crean es nuevo. Los misioneros de inteligencia artificial a menudo Compara estos sistemas con artistas reales. Los creadores se inspiran en todos los que los precedieron, entonces, ¿por qué no hacer que la IA sea similar al trabajo anterior?

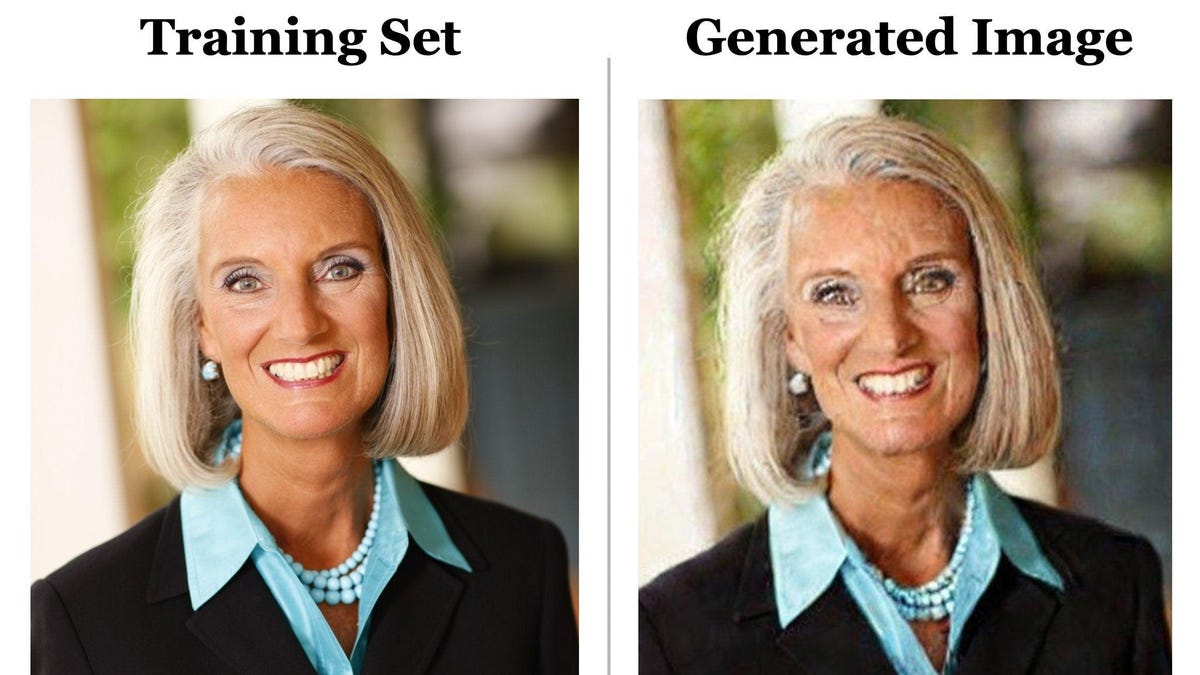

La nueva investigación podría bloquear ese argumento, e incluso podría convertirse en un importante punto de conflicto. Varias demandas en curso relacionadas con contenido generado por IA y derechos de autor. Investigadores tanto de la industria como del mundo académico han descubierto que los generadores de imágenes de IA más populares y futuros pueden «guardar» imágenes a partir de los datos con los que han sido capacitados. En lugar de crear algo completamente nuevo, algunas indicaciones harán que la IA simplemente reproduzca una imagen. Algunas de estas imágenes recreadas pueden tener derechos de autor. Pero lo que es peor, los modelos generativos de IA modernos tienen la capacidad de guardar y reproducir información confidencial recopilada para su uso en un conjunto de entrenamiento de IA.

estudiando Realizado por investigadores tecnológicos, para ser exactos El Google y DeepMind, y en universidades como Berkeley y Princeton. El mismo equipo trabajó en estudio previo que identificó un problema similar con los modelos de lenguaje de IA, específicamente GPT2, Introducción a los modelos OpenAI ChatGPT es muy popular. Reuniendo a la banda, los investigadores dirigidos por el investigador de Google Brain, Nicholas Carlini, descubrieron que tanto Imagen de Google como el popular Stable Diffusion de código abierto podían reproducir las imágenes, algunas de las cuales tenían implicaciones obvias de derechos de autor o licencias para las imágenes.

La primera imagen en ese tweet se creó utilizando el título incluido en el conjunto de datos Stable Diffusion, la base de datos de imágenes fragmentadas de varios terabytes conocida como LAION. El equipo introdujo la leyenda en el mensaje «Difusión estable» y obtuvieron exactamente la misma imagen, aunque ligeramente distorsionada por el ruido digital. El proceso de encontrar estas fotos duplicadas fue relativamente simple. El equipo ejecutó el mismo mensaje varias veces y, después de obtener la misma imagen resultante, los investigadores verificaron manualmente si la imagen estaba presente en el conjunto de entrenamiento.

G/O Media puede ganar una comisión

Dos de los investigadores del artículo, Eric Wallace, estudiante de doctorado en UC Berkeley, y Vikash Siwag, estudiante de doctorado en la Universidad de Princeton, le dijeron a Gizmodo en una entrevista de Zoom que la replicación de imágenes es rara. Su equipo probó alrededor de 300 000 subtítulos diferentes y encontró una tasa de memorización de solo el 0,3 %. Las imágenes duplicadas fueron mucho más raras para modelos como Stable Diffusion que deduplicaron imágenes en su conjunto de entrenamiento, aunque al final todos los modelos de difusión tendrán el mismo problema, en mayor o menor grado. Los investigadores descubrieron que Imagen podía memorizar perfectamente imágenes que solo existían una vez en el conjunto de datos.

“La advertencia aquí es que se supone que el modelo generaliza, y se supone que genera nuevas imágenes en lugar de escupir una copia guardada en la memoria”, dijo Sehwag.

Su investigación muestra que a medida que los sistemas de IA se vuelven más grandes y complejos, aumenta la probabilidad de que la IA produzca material replicado. Un modelo más pequeño como Stable Diffusion simplemente no tiene la misma cantidad de espacio de almacenamiento para almacenar la mayoría de los datos de entrenamiento. eso Mucho podría cambiar en los próximos años.

«Tal vez el próximo año, cualquiera que sea el nuevo modelo que salga, que sea mucho más grande y mucho más poderoso, ese tipo de riesgos de conservación probablemente serán mucho mayores de lo que son ahora», dijo Wallace.

A través de un proceso complejo que implica destruir los datos de entrenamiento con ruido antes de eliminar la misma deformación, los modelos de aprendizaje automático basados en difusión generan datos, en este caso, imágenes, similares a los que se entrenaron en ellos. Los modelos de difusión fueron una evolución de las redes antagónicas generativas o el aprendizaje automático basado en GAN.

Los investigadores descubrieron que los modelos basados en GAN no tienen el mismo problema para guardar imágenes, pero es poco probable que las grandes empresas vayan más allá de Diffusion a menos que surja un modelo de aprendizaje automático más sofisticado que produzca imágenes más realistas y de mayor calidad.

Florian Trammer, profesor de ciencias de la computación en ETH Zurich que participó en la investigación, señaló cuántas empresas de IA aconsejan a los usuarios, ya sea en versiones gratuitas o de pago, que otorguen una licencia para compartir o incluso monetizar contenido generado por IA. Las propias empresas de IA también se reservan algunos derechos sobre estas imágenes. Esto podría ser un problema si la IA crea una imagen que coincide exactamente con los derechos de autor existentes.

Con una tasa de ahorro de solo el 0,3 %, los desarrolladores de IA pueden ver este estudio y determinar que no hay demasiado riesgo. Las empresas pueden trabajar para eliminar los duplicados de imágenes en los datos de entrenamiento, lo que hace que sea menos probable que se guarden. Demonios, incluso podrían desarrollar sistemas de IA que puedan detectar si una imagen es un duplicado directo de una imagen en los datos de entrenamiento y marcarla para su eliminación. Sin embargo, oculta el riesgo total de privacidad que plantea la IA generativa. Carlini y Trammer también ayudaron Otro papel reciente A lo que argumenté que incluso los intentos de filtrar los datos no impidieron que los datos de entrenamiento se filtraran a través del modelo.

Y, por supuesto, existe un gran riesgo de que aparezcan en las pantallas de los usuarios imágenes que nadie quiere reproducir. Wallace preguntó si el investigador quería crear un conjunto completo de datos médicos sintéticos para radiografías de personas, por ejemplo. Qué debería pasar si se salva la inteligencia artificial basada en la difusión ¿Y duplicar los registros médicos reales de una persona?

«Es muy raro, por lo que es posible que no note que está sucediendo al principio, y luego puede publicar ese conjunto de datos en la web», dijo el estudiante de UC Berkeley. «El objetivo de este trabajo es adelantarse a esos posibles tipos de errores que la gente podría cometer».

«Experto en Internet. Introvertido. Adicto al viaje. Evangelista del café. Escritor. Pensador. Entusiasta de la comida extrema. Lector».

More Stories

Resumen del episodio 8 de Agatha All Along

Los premios Grammy se trasladarán a Disney desde CBS en 2027

Jimmy Kimmel: 'El monólogo de esta noche es para los republicanos'